Original (English):

[00:00.000 –> 00:15.860]

I want to thank the organizers for choosing a paper for this award. It was very nice. And I also want to thank my incredible co-authors and collaborators, Oriol Vinyals and Quoc Le, who stood right before you a moment ago. And what you have here is an image, a screenshot, from a similar talk 10 years ago at NeurIPS in 2014 in Montreal. It was a much more innocent time.

[00:15.860 –> 00:35.980]

Here we are, shown in the photos. This is the before. Here’s the after, by the way. And now we’ve got my experienced, hopefully visor. But here I’d like to talk a little bit about the work itself and maybe a 10-year retrospective on it. Because a lot of the things in this work were correct, but some not so much. We can review them and see what happened and how it gently flowed to where we are today.

[00:35.980 –> 00:54.920]

So let’s begin by talking about what we did. The summary of what we did is the following three bullet points: It’s an autoregressive model trained on text. It’s a large neural network. And it’s a large data set. That’s it. Now let’s dive into the details a little bit more. This was a slide 10 years ago. Not too bad. The deep learning hypothesis.

[00:54.920 –> 01:15.060]

What we said here is that if you have a large neural network with 10 layers, it can do anything that a human being can do in a fraction of a second. Why did we emphasize things that human beings can do in a fraction of a second? If you believe the deep learning dogma, that artificial neurons and biological neurons are similar, and you believe real neurons are slow, then anything we can do quickly, a big 10-layer neural network can do too.

[01:15.060 –> 01:36.960]

We focused on 10-layer neural networks because that’s what we knew how to train back then. If you could go beyond 10 layers, you could do more. A different slide from the talk shows our main idea. You might recognize that something autoregressive is going on here. This slide says that if you have an autoregressive model and it predicts the next token well enough, it will capture the correct distribution over sequences that come next.

[01:36.960 –> 01:57.540]

This was relatively new. It wasn’t the first-ever autoregressive neural network, but it was the first where we believed that training it really well would achieve what we wanted. Our task then was translation. Now, let’s look at some ancient history – the LSTM. For those unfamiliar, an LSTM is what deep learning researchers used before transformers. It’s like a ResNet but rotated 90 degrees.

[01:57.540 –> 02:22.880]

Another cool feature from that old talk was parallelization, specifically pipelining, with one layer per GPU. Was it wise to pipeline? As we know now, no, but we got a 3.5x speedup using eight GPUs. The conclusion slide from back then hinted at the beginning of the scaling hypothesis: if you have a big dataset and a big neural network, success is guaranteed. And this has indeed been the trend.

[02:22.880 –> 02:44.100]

One core idea that stood the test of time is connectionism – the belief that artificial neurons are somewhat like biological ones. If you accept that, it gives confidence that large neural networks, even if smaller than the human brain, can perform many tasks we do. However, there’s still a difference: the brain reconfigures itself, while our learning algorithms require as many data points as parameters.

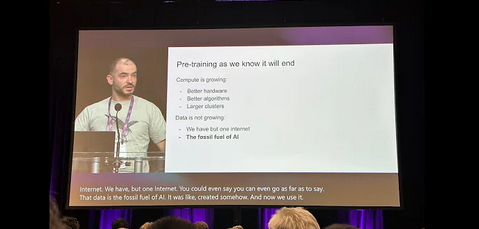

[02:44.100 –> 03:08.960]

This led to the age of pre-training, driven by models like GPT-2, GPT-3, and the scaling laws. Shoutout to my collaborators Alec Radford, Jared Kaplan, and Dario Amodei for making this work. But pre-training will end eventually. Compute grows through better hardware, algorithms, and clusters, but data isn’t growing because we have just one internet. Data is the fossil fuel of AI – finite and peaking.

[03:08.960 –> 03:32.000]

Speculating on what comes next: you may hear about agents, synthetic data, or inference-time compute, like the O1 model. These are paths people are exploring post-pre-training. One interesting biological insight is the brain-to-body mass relationship in mammals. Hominids have a different scaling exponent, showing that biology found ways to scale differently – a hint that we can innovate beyond our current scaling.

[03:32.000 –> 03:54.720]

Looking longer term, we’re heading toward superintelligence, qualitatively different from current models. Future systems will reason effectively and be more agentic. They won’t get confused and will understand things from limited data. Self-awareness could emerge, making these systems radically different. While unpredictable, this progress is astounding, and the field will figure out what’s next.

[03:54.720 –> 04:17.000]

Thank you so much for the talk. It’s been wonderful.

Deutsch:

[00:00.000 –> 00:15.860]

Ich möchte mich bei den Organisatoren bedanken, dass sie unser Paper für diese Auszeichnung ausgewählt haben. Es war wirklich schön. Ich möchte auch meinen unglaublichen Mitautoren und Kollaborateuren, Oriol Vinyals und Quoc Le, danken, die vorhin hier auf der Bühne standen.

[00:15.860 –> 00:29.280]

Hier sehen Sie ein Bild, einen Screenshot, von einem ähnlichen Vortrag vor zehn Jahren auf der NeurIPS 2014 in Montreal. Es war eine viel unschuldigere Zeit. Hier sehen Sie uns auf dem Foto – das „Vorher“. Hier ist übrigens das „Nachher“.

[00:29.280 –> 00:43.300]

Jetzt habe ich hoffentlich ein wenig Erfahrung gesammelt. Aber ich möchte hier ein bisschen über die Arbeit selbst sprechen und vielleicht eine 10-jährige Rückschau darauf geben. Denn vieles in dieser Arbeit war korrekt, anderes nicht so sehr. Wir können darüber sprechen und sehen, wie sich alles zu dem entwickelt hat, wo wir heute stehen.

[00:43.300 –> 00:58.640]

Lassen Sie uns damit beginnen, was wir gemacht haben. Kurz zusammengefasst sind es drei Punkte: Es handelt sich um ein autoregressives Modell, das auf Text trainiert wurde. Es ist ein großes neuronales Netzwerk. Und es wurde mit einem großen Datensatz trainiert. Das war’s. Jetzt tauchen wir ein wenig tiefer in die Details ein.

[00:58.640 –> 01:15.060]

Hier sehen Sie eine Folie von vor zehn Jahren. Gar nicht schlecht – die „Deep Learning“-Hypothese. Damals sagten wir, dass ein großes neuronales Netzwerk mit 10 Schichten alles tun kann, was ein Mensch in einem Bruchteil einer Sekunde tun kann.

[01:15.060 –> 01:27.880]

Warum diese Betonung auf Aufgaben, die Menschen schnell erledigen können? Wenn man der „Deep Learning“-Dogma glaubt, dass künstliche und biologische Neuronen ähnlich sind, und dass biologische Neuronen langsam sind, dann folgt daraus, dass alles, was ein Mensch schnell tun kann, auch ein 10-Schichten-Neuronales-Netzwerk leisten kann.

[01:27.880 –> 01:46.020]

Damals konnten wir nur 10 Schichten effektiv trainieren, deswegen haben wir uns auf diese schnelle menschliche Verarbeitung fokussiert. Eine weitere Folie aus diesem Vortrag zeigt unsere Hauptidee: Wenn ein autoregressives Modell das nächste Token gut genug vorhersagt, erfasst es die richtige Verteilung für die folgenden Sequenzen.

[01:46.020 –> 02:01.040]

Das war damals eine relativ neue Idee. Es war nicht das erste autoregressive neuronale Netzwerk, aber das erste, bei dem wir glaubten: Wenn man es gut trainiert, bekommt man die gewünschten Ergebnisse – damals war das die audazielle Aufgabe der Übersetzung.

[02:01.040 –> 02:15.540]

Ein weiteres Beispiel aus dieser Zeit ist das LSTM, ein Vorläufer der Transformer. Es war wie ein ResNet, aber um 90 Grad gedreht. LSTMs waren damals unsere Werkzeuge, und wir haben Parallelisierung genutzt – genauer gesagt Pipelines, was uns eine 3,5-fache Beschleunigung mit acht GPUs brachte.

[02:15.540 –> 02:36.220]

Die Schlussfolgerungsfolie zeigte damals den Beginn der Skalierungshypothese: Mit einem sehr großen Datensatz und einem sehr großen neuronalen Netzwerk ist Erfolg garantiert. Diese Idee hat sich bewahrheitet und führte zum Zeitalter des Pre-Trainings, zu Modellen wie GPT-2 und GPT-3.

[02:36.220 –> 02:54.420]

Doch Pre-Training wird ein Ende haben. Während Rechenleistung durch bessere Hardware und Algorithmen zunimmt, wächst der Datensatz nicht weiter, da wir nur ein Internet haben. Daten sind der fossile Brennstoff der KI. Wir müssen also mit dem arbeiten, was wir haben.

[02:54.420 –> 03:15.720]

Was kommt danach? Viele spekulieren über Agenten, synthetische Daten oder neue Berechnungsansätze zur Inferenzzeit. Es wird Veränderungen geben, und die Gemeinschaft wird neue Wege finden, wie die Biologie uns gezeigt hat, dass Skalierung unterschiedlich erfolgen kann.

[03:15.720 –> 03:30.000]

In der langfristigen Perspektive werden Systeme entstehen, die tatsächlich agentisch handeln, logisch schlussfolgern und weniger Fehler machen. Dies wird zu Systemen mit völlig neuen Qualitäten führen, die unsere heutigen Möglichkeiten übertreffen.

[03:30.000 –> 03:44.580]

Vielen Dank für Ihre Aufmerksamkeit!

Türkçe

[00:00.000 –> 00:15.860]

Bu makalemizi ödüle layık gördükleri için organizatörlere teşekkür etmek istiyorum. Gerçekten çok güzeldi. Ayrıca burada daha önce sahneye çıkan inanılmaz yazar arkadaşlarım ve işbirlikçilerim Oriol Vinyals ve Quoc Le’ye de teşekkür ediyorum.

[00:15.860 –> 00:29.280]

Burada on yıl önce, 2014 NeurIPS Montreal’de yaptığım benzer bir konuşmadan bir ekran görüntüsü görüyorsunuz. Çok daha masum bir zamandı. Fotoğrafta bizi görebilirsiniz – bu “öncesi” hâli. İşte bu da “sonrası”.

[00:29.280 –> 00:43.300]

Şimdi umarım biraz deneyim kazanmışımdır. Ancak burada çalışmanın kendisinden ve 10 yıl geriye dönüp bakışımızdan bahsetmek istiyorum. Çünkü bu çalışmanın bazı kısımları doğruydu, bazı kısımları ise o kadar değil. Bugün geldiğimiz noktaya nasıl ulaştığımızı birlikte inceleyelim.

[00:43.300 –> 00:58.640]

Ne yaptığımızı özetlemek gerekirse üç madde: Bu bir otoregresif modeldi, metin üzerinde eğitildi. Büyük bir sinir ağıydı. Ve büyük bir veri seti ile eğitildi. Hepsi bu. Şimdi detaylara biraz daha derinlemesine bakalım.

[00:58.640 –> 01:15.060]

Bu, on yıl önceki bir slayt. Hiç de fena değil – “Derin Öğrenme” hipotezi. O zamanlar, 10 katmanlı büyük bir sinir ağının, insanın bir saniyenin küçük bir parçasında yapabildiği her şeyi yapabileceğini söylemiştik.

[01:15.060 –> 01:27.880]

Neden hızlı yapılan insan görevlerine odaklandık? Eğer derin öğrenmenin yapay ve biyolojik nöronların benzer olduğunu söylediğine inanıyorsanız ve biyolojik nöronların yavaş çalıştığını kabul ediyorsanız, o zaman insanın hızlı yaptığı her şeyi 10 katmanlı bir sinir ağı da yapabilir.

[01:27.880 –> 01:46.020]

O zamanlar sadece 10 katmanı etkili bir şekilde eğitebiliyorduk. Bu yüzden hızlı insan işlemlerine odaklandık. O dönemdeki bir başka önemli fikir de şuydu: Eğer bir otoregresif model bir sonraki token’i yeterince iyi tahmin ederse, doğru dizilim dağılımını yakalar.

[01:46.020 –> 02:01.040]

Bu, o zamanlar nispeten yeni bir fikirdi. İlk otoregresif sinir ağı değildi, ancak doğru eğitilirse istenen sonuca ulaşacağımıza inanıyorduk – o zaman bu görev çeviri yapmaktı.

[02:01.040 –> 02:15.540]

O dönemin bir diğer örneği de LSTM’lerdi. Transformer’ların öncüsü olan LSTM’ler, 90 derece döndürülmüş bir ResNet gibiydi. LSTM’ler bizim araçlarımızdı ve paralelleştirme yapıyorduk. Özellikle pipeline kullanarak sekiz GPU ile 3,5 kat hızlanma elde ettik.

[02:15.540 –> 02:36.220]

Sonuç slaytımızda, ölçekleme hipotezinin başlangıcını görebilirsiniz: Çok büyük bir veri seti ve çok büyük bir sinir ağı ile başarı garanti edilir. Bu fikir doğrulandı ve ön eğitim dönemine, GPT-2 ve GPT-3 gibi modellere yol açtı.

[02:36.220 –> 02:54.420]

Fakat ön eğitim bir noktada sona erecek. Hesaplama gücü daha iyi donanım ve algoritmalarla artıyor, ancak veri setleri büyümüyor. Çünkü elimizde sadece bir internet var. Veri, yapay zekanın fosil yakıtıdır. Mevcut verilerle yetinmek zorundayız.

[02:54.420 –> 03:15.720]

Bundan sonra ne olacak? Birçok kişi ajanlar, sentetik veriler veya yeni çıkarım yöntemleri üzerine spekülasyon yapıyor. Değişimler olacak ve topluluk, biyolojinin bize öğrettiği gibi, ölçeklemeyi farklı şekillerde gerçekleştirecek.

[03:15.720 –> 03:30.000]

Uzun vadede, gerçekten ajan gibi hareket eden, mantıksal çıkarımlar yapabilen ve daha az hata yapan sistemler ortaya çıkacak. Bu, yepyeni niteliklere sahip sistemler doğuracak ve şu anki yeteneklerimizi aşacak.

[03:30.000 –> 03:44.580]

Dikkatiniz için çok teşekkür ederim!

Views: 15